L’intelligenza artificiale generativa in ambito sanitario

La discussione italiana ed europea tra opportunità, rischi e sfide etiche

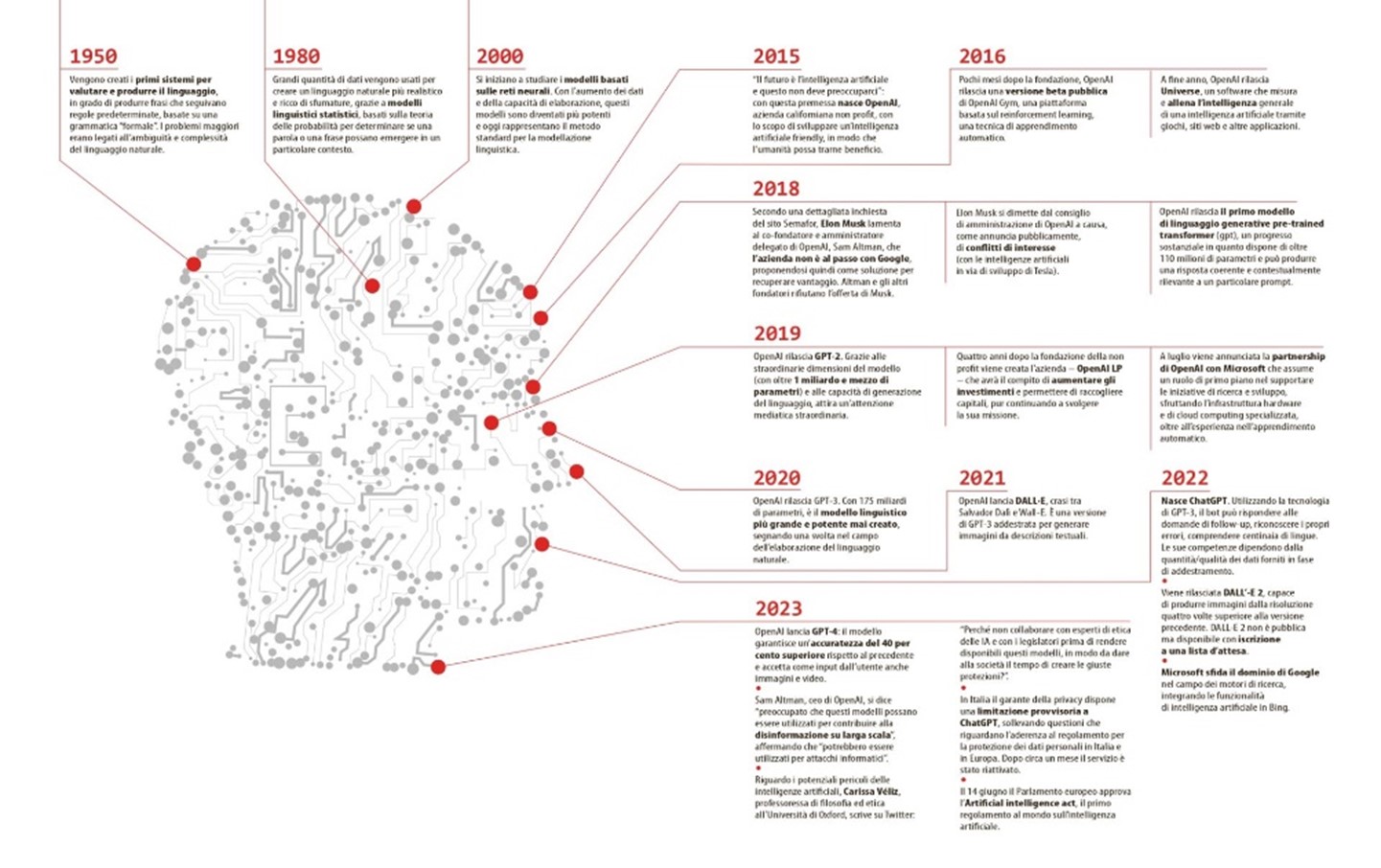

GPT è l'acronimo di Generative Pre-trained Transformer, una tecnologia di apprendimento automatico che utilizza le reti neurali per elaborare le informazioni grezze in ingresso e trasformarle in qualcosa di comprensibile e convincente per gli esseri umani. L’evoluzione di questa nuova tecnologia ha una velocità senza precedenti nella storia dei progressi scientifici.

¹ Fonte: ‘Forward’ ChatGPT Timeline -La frenetica crescita di ChatGPT

Il lancio e la rapida crescita di ChatGPt

Dopo il lancio di ChatGPt nel 2022, capace di rispondere alle domande di follow up degli utenti, comprendere migliaia di lingue e imparare dai propri errori, a febbraio 2023 ChatGPT3.5 ha raggiunto 100 milioni di utenti, più in fretta di TikTok (che ha maturato questa diffusione in nove mesi) e Instagram (che ci è arrivato in due anni e mezzo).

Il 14 Marzo 2023 OpenAI Lancia ChatGPT4. Rispetto alla precedente questa versione accetta come input non più soltanto messaggi relativamente brevi di solo testo, ma anche contenuti multimediali come immagini e video, oltre che testi molto più ampi (fino a 25.000 parole).

Dimostra una accuratezza superiore del 40% paragonata alla release di pochi mesi prima, e lo stesso CEO di OpenAI, Sam Altman, si dichiara preoccupato che la tecnologia possa essere utilizzata per costruire, diffondere e convincere in base a fake news, anche a vantaggio di regimi autoritari.

Italia - Il tema della privacy blocca ChatGPT

Nemmeno un mese dopo il lancio l’autorità garante della privacy in Italia blocca l’accesso alla piattaforma sul nostro territorio argomentando che:

- OpenAI non ha correttamente informato gli utenti che ha raccolto dati personali.

- OpenAI non ha fornito una ragione legale per la raccolta di informazioni personali per addestrare il suo algoritmo.

- ChatGPT elabora le informazioni personali in modo impreciso senza l'uso di fatti reali.

- OpenAI non ha richiesto agli utenti di verificare la loro età, anche se il contenuto generato da ChatGPT è destinato agli utenti di età superiore ai 13 anni e richiede il consenso dei genitori per quelli sotto i 18 anni.

A fine aprile – Il Garante rilascia una dichiarazione che OpenAI ha soddisfatto le sue richieste e che il servizio ChatGPT viene riattivato.

La posizione dell’Europa

La risoluzione del caso italiano arriva alla vigilia della votazione da parte del parlamento europeo dell'Artificial Intelligence Act il 14 giugno, che mira a regolamentare la tecnologia AI e potrebbe avere un impatto sugli strumenti di IA generativa in futuro. Il documento pone le basi per alcuni importanti orientamenti e limiti nell’utilizzo dell’intelligenza artificiale nella regione europea, in particolare per controllare l’utilizzo in senso predittivo del comportamento umano e per verificare la sicurezza delle applicazioni sulla salute.

La discussione sull’utilizzo dei modelli LLM o intelligenza artificiale generativa in ambito sanitario è sempre più spesso a chiosa delle analisi sulle possibili applicazioni e vantaggi per medici e pazienti.

Le raccomandazioni e le preoccupazioni dei guru della nuova medicina

In luglio il Nature Digital Medicine pubblica un articolo molto argomentato di Bertalan Meskò, direttore del Medical Futurist Institute ed Eric Topol professore di medicina molecolare a key note speaker famoso per i suoi interventi sul futuro della scienza medica, con un titolo molto significativo: ‘The imperative for regulatory oversight of large language models (or generative AI) in healthcare’. I due autori confermano la loro fiducia nelle potenzialità delle applicazioni di IA generativa in medicina, ma individuano come improrogabile la necessità di definirne i confini regolatori sintetizzando le principali sfide da fronteggiare:

|

|

Elenco di sfide normative legate allo sviluppo delle LLM |

|

Problema |

Descrizione |

|

Privacy dei dati dei pazienti |

Garantire che i dati dei pazienti utilizzati per la formazione di modelli linguistici di grandi dimensioni siano completamente anonimizzati e protetti da potenziali violazioni. Ciò rappresenta una sfida normativa significativa, in quanto qualsiasi violazione potrebbe portare a gravi conseguenze ai sensi delle leggi sulla privacy, come HIPAA negli Stati Uniti. |

|

Proprietà intellettuale |

Se un LLM genera contenuti simili alla ricerca medica proprietaria o alla letteratura, potrebbe portare a problemi relativi ai diritti di proprietà intellettuale. |

|

Responsabilità per negligenza medica |

Determinare chi è responsabile quando le raccomandazioni di un'IA portano a danni al paziente. Sono gli sviluppatori di intelligenza artificiale, gli operatori sanitari che lo hanno utilizzato o le istituzioni che lo hanno adottato? |

|

Controllo qualità e standardizzazione |

La regolamentazione è necessaria per garantire l'affidabilità e la coerenza della consulenza medica generata dall'IA, che può variare in base ai dati utilizzati per addestrare l'IA. |

|

Consenso informato |

I pazienti devono essere informati e dare il consenso quando gli strumenti di intelligenza artificiale vengono utilizzati nella loro gestione sanitaria. Questo è impegnativo perché può essere difficile per i pazienti comprendere appieno le implicazioni dell'uso dell'IA. |

|

Interoperabilità e trasparenza |

I regolamenti sull'interpretabilità e sulla trasparenza devono garantire la trasparenza su come le decisioni vengono prese dall'IA. Ciò è particolarmente impegnativo con i modelli di intelligenza artificiale che sono spesso definiti come "scatole nere" a causa dei loro complessi algoritmi. |

|

Equità e verifica dei bias |

La regolamentazione dell'equità e dei pregiudizi è necessaria per prevenire distorsioni nei modelli di IA, che potrebbero essere introdotti durante il processo di formazione utilizzando i dati dei pazienti. Ciò può portare a disparità nei risultati sanitari. |

|

Proprietà dei dati |

Può essere difficile definire e regolamentare chi possiede i dati da cui i modelli linguistici di grandi dimensioni apprendono, soprattutto quando si tratta di dati dei pazienti. |

|

Eccessivo affidamento sui modelli di IA |

L'eccessiva dipendenza dall'IA potrebbe portare a una diminuzione delle competenze umane e a potenziali errori se l'IA non funziona correttamente o fornisce informazioni errate. Sono necessari regolamenti per bilanciare l'uso dell'IA e delle competenze umane. |

|

Monitoraggio e convalida continui |

Garantire le prestazioni, l'accuratezza e la validità continue degli strumenti di intelligenza artificiale nel tempo e tra le diverse popolazioni è una sfida normativa critica. |

Adattato da: Meskó B, Topol EJ. The imperative for regulatory oversight of large language models (or generative AI) in healthcare. NPJ Digit Med. 2023 Jul 6;6(1):120. doi: 10.1038/s41746-023-00873-0. PMID: 37414860; PMCID: PMC10326069.

Gli autori non fanno sconti rispetto ai temi posti alla politica e agli organismi regolatori, nella convinzione che le LLM offrono enormi promesse per il futuro dell'assistenza sanitaria, ma il loro uso comporta importanti rischi e sfide etiche superabili solo con un approccio proattivo sulla regolamentazione, capace di preservare la fiducia di pazienti e di operatori sanitari coinvolti.

RIFERIMENTI

- 1 Forward’ ChatGPT Timeline -La frenetica crescita di ChatGPT

Cliccando sul seguente link abbandonerà questo sito e accedendo al sito appena selezionato lei sarà soggetto alle condizioni di utilizzo di questo ultimo.

Polifarma non si assume alcuna responsabilità relativamente ai contenuti presenti.

Forward’ ChatGPT Timeline -La frenetica crescita di ChatGPT - 2 The imperative for regulatory oversight of large language models (or generative AI) in healthcare

Cliccando sul seguente link abbandonerà questo sito e accedendo al sito appena selezionato lei sarà soggetto alle condizioni di utilizzo di questo ultimo.

Polifarma non si assume alcuna responsabilità relativamente ai contenuti presenti.

The imperative for regulatory oversight of large language models (or generative AI) in healthcare